Umetna inteligenca (krajše UI oz. AI – artificial intelligence) se je iz znanstvene fantastike spremenila v nepogrešljiv del našega vsakdanjega življenja. Najdemo jo praktično povsod, recimo v virtualnih asistentih, kot sta Siri in Alexa, v samovozečih avtomobilih in pri napredni medicinski diagnostiki. V tem članku vam bomo predstavili kratek pregled zgodovine AI, od zgodnjih mehanskih izumov do sodobne dobe globokega učenja (deep learning) in velikih jezikovnih modelov (large language models – LLM). Z razumevanjem poteka razvoja ter poznavanjem mejnikov in prelomnic, ki so oblikovali evolucijo AI, bomo lažje ocenili njen ogromni potencial za razvoj v prihodnosti ter vpliv na vse dele družbe.

Najpomembnejši zgodnji mejniki v razvoju AI

ELIZA (1964): pionirska obdelava naravnega jezika (natural language processing)

Leta 1964 jo je razvil Joseph Weizenbaum. Predstavlja enega prvih in hkrati najvplivnejših primerov obdelave naravnega jezika (NLP) v umetni inteligenci. Revolucionarni program je bil zasnovan za simulacijo človeškega pogovora prek interakcij z besedilom, pri čemer je s tehniko iskanja vzorcev analiziral vhodne podatke uporabnika in odgovarjal s predhodno določenimi scenariji, kar je ustvarilo iluzijo sodelovanja v smiselnem pogovoru, razumevanja in sočutja.

SHRDLU (1970): napredek pri razumevanju naravnega jezika in modeliranju sveta

Terry Winograd je idejni oče sistema, ki predstavlja pomemben korak zlasti na področjih razumevanja naravnega jezika in modeliranja sveta. SHRDLU je komuniciral prek besedilnih ukazov, kar je uporabnikom omogočilo manipulacijo v preprostem virtualnem okolju, sestavljenem iz različnih geometrijskih oblik. Pomembna je tudi njegova sposobnost inteligentne razlage in obdelave vhodnih podatkov z uporabo robustnega razumevanja sintakse, semantike in konteksta.

MYCIN (1972): pionirski strokovni sistem za medicinsko diagnozo

MYCIN sta leta 1972 na Univerzi Stanford razvila Edward Shortliff in Bruce Buchanan. Zgodnji strokovni sistem je bil zasnovan za revolucijo medicinske diagnostike, zlasti na področju infekcijskih bolezni. Za prepoznavanje povzročiteljev bakterijskih okužb in priporočanje ustreznih antibiotičnih zdravljenj z upoštevanjem dejavnikov, kot so alergije na zdravila in odpornost, je uporabljal sistem, ki je temeljil na obsežni zbirki implikacij oz. pravil »če A, potem B«.

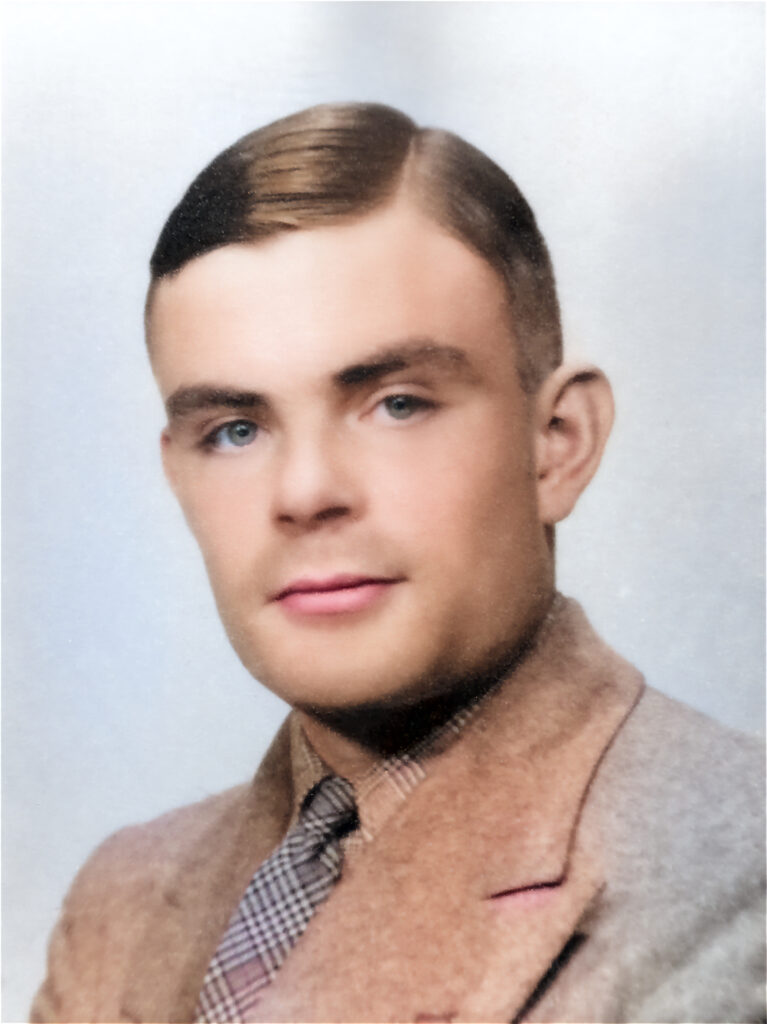

Začetki umetne inteligence

Temelje sodobne umetne inteligence je s svojimi pionirskimi idejami v zgodnjem 20. stoletju postavil genialni britanski matematik in računalniški znanstvenik Alan Turing. Ključni mejnik je bil Turingov test leta 1950, znan tudi kot igra posnemanja, s katerim so ocenjevali sposobnosti stroja, da pokaže človeku podobno inteligenco. V tem testu se človeški zasliševalec hkrati pogovarja s človekom in s strojem, pri tem pa ne ve, kateri odgovori so čigavi. Če ne more zanesljivo ločiti odgovorov stroja od odgovora človeka, se šteje, da je stroj opravil test in pokazal raven inteligence, podobne človeški.

Izraz umetna inteligenca so prvič uporabili leta 1956 na konferenci v Dartmouthu v ZDA, kjer so postavili drzno trditev, »da se načeloma da vsak vidik učenja ali katere koli druge prvine inteligence tako natančno opisati, da je možno izdelati stroj, ki zna to simulirati.« Udeleženci konference so skušali razumeti, kako bi lahko stroje programirali tako, da bi opravljali naloge, ki običajno zahtevajo človeško inteligenco, na primer reševanje problemov, razumevanje naravnega jezika in učenje.

Zima umetne inteligence in njeno ponovno oživljanje

V 70. in 80. letih 20. stoletja je nastopilo obdobje t. i. zime umetne inteligence, ko sta to področje doletela zmanjšanje financiranja in upočasnitev napredka v raziskavah. Težave pri obvladovanju zapletenosti resničnih scenarijev so povzročile razočaranje in skepticizem glede potenciala umetne inteligence, pomanjkanje računalniške moči in omejen dostop do velikih podatkovnih zbirk pa sta ovirala razvoj naprednejših modelov AI.

Trend se je v 90. letih obrnil. Napredek strojnega učenja in povečanje računalniških zmogljivosti sta privedla do oživitve raziskav na področju umetne inteligence, z razvojem algoritmov, kot je povratno učenje (reinforcement) za usposabljanje nevralnih mrež, in uvedbo podpornih vektorskih strojev pa sta se vrnila tudi zanimanje in optimizem. Sistemi umetne inteligence so začenjali prepoznavati vzorce, pri sprejemanju odločitev se niso več zanašali zgolj na vnaprej določena pravila, ampak na podatke.

Doba globokega učenja

Globoko učenje (deep learning) vključuje uporabo več plasti nevronskih mrež, ki sta jih navdihnili struktura in funkcija človeških možganov. Zasnovano je za prepoznavanje vzorcev in učenje iz podatkov (prepoznavanje govora in slik, razumevanje in ustvarjanje besedil in glasbe ter podobno), nevroni v nevronskih mrežah pa informacije obdelujejo skozi plasti in prilagajajo svoje notranje povezave na podlagi vhodnih podatkov.

Ponoven razvoj je prinesel veliko novih prebojnih mejnikov na različnih področjih umetne inteligence:

- Leta 2010 so na tekmovanju ImageNet s predstavitvijo oz. uvedbo konvolucijskih nevronskih mrež (convolutional neural networks – CNN) dosegli pomemben preskok na področju računalniškega vida in presegli druge tehnike prepoznavanja slik. CNN za prepoznavanje slik uporabljajo aplikacije za prepoznavanje obrazov, avtonomna vozila in tehnologije za medicinsko slikanje.

- Leta 2016 se je svetovni prvak v igri go Lee Sedol pomeril z globoko nevronsko mrežo AlphaGo podjetja DeepMind in – izgubil! Program AlphaGo je uporabljal kombinacijo spodbujevanega učenja (reinforcement learning) in najprej preučil vse pretekle igralne zapise goja, nato pa igral sam proti sebi in se izpopolnjeval. Mimogrede, že leta 1997 je DeepBlue v šahu premagal velemojstra Kasparova.

Veliki jezikovni modeli (LLM)

Obdelava naravnega jezika (NLP) je področje umetne inteligence, ki se osredotoča na to, da strojem omogoča razumevanje, razlaganje in ustvarjanje človeškega jezika. Jezikovni modeli izkoriščajo NLP, saj si prizadevajo napovedati verjetnost zaporedij besed, kar zajema strukturo in nianse naravnega jezika. Ti modeli predstavljajo osnovo za različne aplikacije NLP, kot so strojno prevajanje, povzemanje besedil in analiza sentimenta.

Kako delujejo LLM

Veliki jezikovni modeli (LLM) so ogromne nevronske mreže, ki se učijo iz velike količine besedilnih podatkov, da lahko razumejo in ustvarjajo jezik, podoben človeškemu. Izkoriščajo zmogljivo arhitekturo transformerjev, ki uporabljajo mehanizme samopozornosti za učenje kontekstualnih razmerij med besedami v danih vhodnih zaporedjih, z usposabljanjem na raznolikih in obsežnih besedilnih korpusih pa lahko ustvarjajo koherentne, vsebinsko ustrezne in slovnično pravilne besedilne izhode. Eden najnaprednejših in najbolj znanih jezikovnih modelov je GPT4, ki je s skoraj neverjetnimi več kot trilijon parametri pokazal izjemno sposobnosti ustvarjanja besedil, dopolnjevanja stavkov, odgovarjanja na vprašanja, generiranja slik, generiranja programske kode in pisanja člankov.

Potencialne aplikacije in etične dileme v zvezi z velikimi jezikovnimi modeli

Poleg izjemnega potenciala za široko paleto aplikacij, vključno z razvojem klepetalnikov, generiranjem vsebine, dopolnjevanjem kode in pomočjo pri ustvarjalnem pisanju, prinaša uporaba velikih jezikovnih modelov tudi etične pomisleke. Možnost ustvarjanja zavajajoče ali škodljive vsebine, ohranjanje pristranskosti v podatkih za usposabljanje modelov in okoljski vpliv usposabljanja tako obsežnih modelov so razlogi za skrb, ki zahtevajo odgovorno ravnanje in obravnavanje teh vprašanj prek raziskav, regulacije in sodelovanja med deležniki.

Drugi pomembni modeli umetne inteligence

Raziskovanje inovacij na področju umetne inteligence poteka tudi na področjih računalniškega vida, obdelave zvoka, robotike in generiranja videoposnetkov iz besedil.

Računalniški vid: R-CNN, YOLO in Mask R-CNN

Računalniški vid strojem omogoča razumevanje in interpretacijo vizualnih informacij. Modeli, ki so revolucionirali področja od nadzora in avtonomnih vozil do medicinskega slikanja in navidezne resničnosti, so R-CNN, YOLO in Mask R-CNN. R-CNN (region-based convolutional neural networks) zaznava, prepoznava in kategorizira predmete na slikah. YOLO (you only look once) z obdelavo slike v enem prehodu zaznava objekte v realnem času. Mask R-CNN razširja zmogljivosti R-CNN z dodajanjem segmentacije primerkov za natančno lokalizacijo in orisovanje objektov na slikah.

Obdelava zvoka: WaveNet in DeepSpeech

WaveNet (DeepMind) je zmogljiv generativni model za sintezo zelo realističnega in ekspresivnega, človeškemu podobnega govora, njegove zmogljivosti pa so bile vključene tudi v Googlovega Pomočnika (Google assistant). DeepSpeech podjetja Mozilla je odprtokodna programska oprema za pretvorbo govora v besedilo, ki uporablja tehnike globokega učenja za pretvorbo govornega jezika v zapisano besedilo. Uporablja se v aplikacijah, kot so pomočniki za glasovno upravljanje, storitve prepisov in orodja za dostopnost za naglušne osebe.

Robotika: Atlas in Spot podjetja Boston Dynamics

Boston Dynamics, vodilno podjetje v segmentu robotike, je razvilo napredne robote z izjemnimi zmogljivostmi na področju mobilnosti, ravnotežja in avtonomije. Njihov Atlas je bipedalni humanoidni robot, ki se odlikuje po spretnosti in gibčnosti pri teku, skakanju in rokovanju z objekti. Spot pa je štirinožni robot, zasnovan za široko paleto aplikacij, kot so pregledovanje okolice, kartiranje in pomoč v nevarnih okoljih. Oba robota predstavljata pravo smer raziskav in razvoja robotike ter možnost sodelovanja med človekom in robotom.

Generiranje slik in videoposnetkov iz besedila

Generiranje slik in videoposnetkov iz besedila je hitro rastoče področje umetne inteligence, ki tekstovne opise pretvarja v realistične slike ali video vsebine. Z izkoriščanjem naprednih tehnik umetne inteligence in razumevanjem naravnega jezika lahko ti modeli ustvarjajo slike različnih stilov, videoposnetke, dinamične prizore in animacije, ki vizualno predstavljajo vhodno besedilo. Možne uporabe generiranja slik in videoposnetkov iz besedila vključujejo ustvarjanje vsebin za trženje, navidezno resničnost in pripovedovanje zgodb ter izobraževalne namene. AI-generatorji videoposnetkov so DAIN, Lumen5, RunwayML, DeepArt.io, Artymate in drugi, slike pa ustvarjajo DALL-E 2, Midjourney, Stable Diffusion, Craiyon (prej DALL-E mini) in Nightcafe AI.

Zaključek

Prihodnost AI prinaša ogromno priložnosti za spreminjanje industrij, izboljšanje odločevalskih procesov in našega vsakdanjega življenja s pomočjo inovacij na področju računalniškega vida, obdelave naravnega jezika in robotike.

A na tej poti ne manjka izzivov. Etična vprašanja, varstvo osebnih podatkov, pristranskost in vpliv avtomatizacije na družbo zahtevajo odgovoren razvoj AI, saj bomo lahko le tako izkoristili ves njen potencial in uživali v prihodnosti, v kateri AI ne bo le inteligenten, ampak tudi koristen za človeštvo.